La dodicesima edizione di OpenDIAG è finita

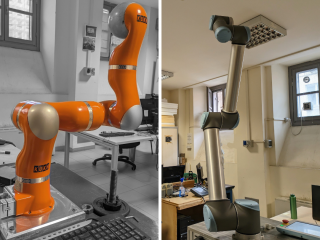

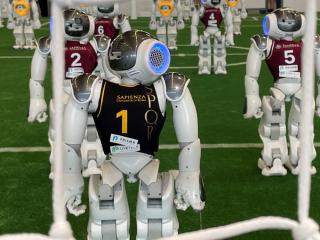

... ed è stata ancora una volta un grande successo. Più di 600 studenti sono venuti a trovarci per conoscere l'offerta formativa e visitare le demo dei nostri laboratori di ricerca. Inoltre anche la nuova edizione dedicata alle scuole medie superiori di primo grado ha registrato un alto gradimento da parte dei più di 120 ragazzi provenienti da 3 scuole che sono intervenuti.

Un grande ringraziamento va all'opera svolta dagli studenti DIAG collaboranti, allo staff e a tutto il Dipartimento che hanno reso possibile anche quest'anno l'organizzazione e la realizzazione di un evento unico nel nostro Ateneo.